Meta heeft de eerste modellen in de Llama 4-reeks aangekondigd. De nieuwe multimodale AI-modellen, Llama 4 Scout en Llama 4 Maverick, bieden sterke contextuele capaciteiten en zijn de eerste open-weight modellen die gebouwd zijn met een mixture-of-experts (MoE) architectuur. Meta claimt dat deze modellen betere prestaties leveren dan concurrerende oplossingen en tegelijkertijd efficiënter zijn in gebruik.

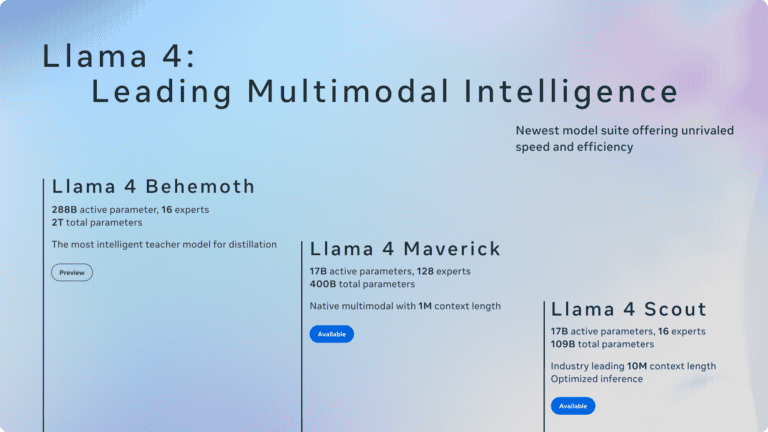

Llama 4 komt in twee varianten: Scout en Maverick. Llama 4 Scout heeft 17 miljard actieve parameters met 16 experts en past op een enkele NvidiaH100 GPU. Dit model ondersteunt een contextvenster van 10 miljoen tokens, wat het mogelijk maakt om enorme hoeveelheden informatie in één keer te verwerken. Hiermee laat het modellen zoals Gemma 3 en Mistral 3.1 achter zich op verschillende benchmarks.

De krachtigere Llama 4 Maverick heeft dezelfde 17 miljard actieve parameters, maar dan met 128 experts en 400 miljard totale parameters. Dit model presteert beter dan GPT-4o en Gemini 2.0 Flash op meerdere benchmarks, terwijl het qua redenering en codering vergelijkbare resultaten boekt als het nieuwe DeepSeek v3 met minder dan de helft van de actieve parameters.

Technologische innovatie

De mixture-of-experts architectuur is een belangrijke innovatie in deze modellen. Bij deze aanpak wordt per token slechts een fractie van de totale parameters geactiveerd, wat zorgt voor aanzienlijke efficiëntieverbeteringen bij zowel training als inferentie. Zo bevat Llama 4 Maverick 400 miljard totale parameters, maar gebruikt het slechts een deel daarvan voor elke berekening.

Een andere belangrijke innovatie is de native multimodaliteit met early fusion, waardoor tekst- en beeldtokens naadloos in het model worden geïntegreerd. Meta heeft ook een verbeterde vision encoder ontwikkeld, gebaseerd op MetaCLIP maar apart getraind in combinatie met een bevroren Llama-model.

Naast de twee beschikbare modellen gaf Meta ook een voorproefje van Llama 4 Behemoth, een 288 miljard actieve parameter model met 16 experts en bijna twee biljoen totale parameters. Dit model, dat nog getraind wordt, presteert volgens Meta beter dan GPT-4.5, Claude Sonnet 3.7 en Gemini 2.0 Pro op verschillende STEM-benchmarks. Behemoth diende als ‘leraar’ voor de kleinere Llama 4-modellen tijdens het trainingproces.

Meta benadrukt dat ze blijft geloven in openheid als drijfveer voor innovatie. Daarom zijn Llama 4 Scout en Llama 4 Maverick nu beschikbaar om te downloaden op llama.com en Hugging Face. Ontwikkelaars kunnen deze modellen inzetten voor het bouwen van nieuwe toepassingen.

Tip: Meta introduceert eerste multimodale modellen van Llama